En este artículo vamos a hacer una crónica de una situación indeseable con la que espero que no tengáis que lidiar nunca. Trataremos de arrojar un poco de luz sobre los efectos en las SERPS después de que Google reciba errores 500 por parte de tu web durante un período de 9 días.

Imagina que realizas una actualización de tu site y que, por el motivo que sea, una pequeña línea de código hace que se produzcan errores 500 de manera aleatoria en algunas urls de tu site y que estos errores 500 no estén monitorizados mediante alertas.

Imagina que empiezas a emitir errores un miércoles y que el viernes te vas de vacaciones hasta el martes. Sabemos que Webmaster Tools no te da datos fiables hasta al menos 72 horas después, con lo cual los primeros errores aparecen el sábado, una cifra pequeña, casi insignificante. Imagina que vuelves de vacaciones el miércoles y compruebas que tienes una gráfica preocupante de errores de rastreo, que empiezan casi una semana antes.

Compruebas que los errores son aleatorios y que por eso no has tenido la «suerte» de cruzarte con ninguno en tus típicas visitas a tu propia web (aun estando de vacaciones). Compruebas, con terror, que no hay alerta de monitorización para esos errores, desconocidos hasta el momento, por lo que ni tú, ni el resto de implicados en la web los han detectado. Comienza la búsqueda del motivo del error y al día siguiente está corregido y subsanado.

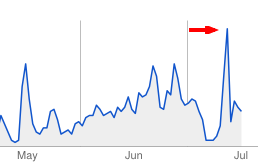

Entras a Webmaster Tools y compruebas que el nivel de errores detectado por el bot ya es considerable y que algo malo va a pasar. Haces el primer check cruzado con datos de Analytics y te das cuenta: estás perdiendo tráfico. Lanzas tu software de monitorización de SERPS y las sospechas son acertadas: hay una bajada en torno al 20-25% de tus KeyWords más importantes y, pese a no haber pasado muchos días, el tráfico se resiente en la misma medida.

Tras comprobar la salud del sitio y que los errores están corregidos y monitorizados, te encargas de marcar con «Mark as fixed» todos los errores de rastreo que Webmaster Tools te ofrece en sus warnings. Ahora solo queda esperar y rezar. Como no tenemos paciencia ni tiempo de rezar, empezamos a buscar patrones de recuperación o posibles penalizaciones «reconocibles».

Empiezas a pensar en una mezcla de Pandas y Pingüinos robotizados que mandan al infierno a las webs que ofrecen una mala experiencia de usuario, que tienen laaargos tiempos de carga y que dan muchos errores de rastreo.

Buscas también ejemplos de webs que hayan pasado por algo similar y no te gusta lo que encuentras… Así que aprovechas para comprobar que no hay otros factores que estén influyendo en la caída de posiciones de tus KW: sabes que tienes una sección que puede «pecar» de contenido duplicado, pese a que te lo curras bien para ofrecer contenidos añadidos relevantes.

Descartas esta posibilidad cuando compruebas que tus urls apenas pasan del 25% de duplicidad con las fuentes originales, aunque claro, esto no te lo garantiza nadie… ¿Acaso sabes cuánto tarda Google en penalizar a una web por estos errores de rastreo? ¿Y cómo las penaliza?

De ahí que te pones a buscar más información para, como siempre, buscar precedentes. Encuentras multitud de artículos (Search Engine Land, SEOMoz, etc…) que hablan de que, aun cuando no es 100% seguro, lo más que probable es que tu sitio y tus rankings sean penalizados si ofreces gran cantidad de errores de servidor.

¿Cuánto es una gran cantidad de errores de rastreo? Digamos que en nuestro caso, el último día que ofrecimos errores devolvimos casi un 50% de las páginas rastreadas ese día como errores 500. Genial, ¿verdad? Google detectó errores y subió su % de rastreo de nuestra web hasta rastrear un 85% del total de urls en ese día.

De momento, y tras comprobar que no has hecho ningún cambio significativo en la estructura de la web, seguiremos aprovechando para comprobar si hay otras causas que hayan podido provocar esta caída del tráfico.

¿Acaso la campaña de comunicación que lanzamos y que nos ha generado miles (literal) de enlaces entrantes en pocos días ha podido ser considerada como un crecimiento extraño y desproporcionado de backlinks?

La totalidad de los enlaces ganados son menciones en webs del sector, notas de prensa y entrevistas… y la gran mayoría son enlaces de marca, o bien con el nombre del proyecto o directamente con la url. No hay anchors optimizados ni manipulación por ninguna parte… En teoría y según todo lo que Google anuncia, es un linkbaiting de lo más natural: noticias y contenidos relevantes que son enlazados. Ni más ni menos. De ahí que descartemos también la penalización por backlinks, habiendo descartado también la remota posibilidad de los contenidos duplicados… parece que todo apunta a una penalización por errores de rastreo.

Es muy dificil aseverar algo así, pero ya tengo una idea para un experimento: generar errores 500 de forma premeditada para medir a partir de qué % y en cuánto tiempo Google te empieza a tirar abajo los rankings. Ojo, no digo que lo vaya a usar para detectar errores 500 en webs de la competencia y crear bucles que reproduzcan el error hasta que Googlebot lo detecte y acabe penalizándolos… eso no va a ocurrir.

Falta saber cuándo y cómo nos recuperaremos. Iremos actualizando este post.

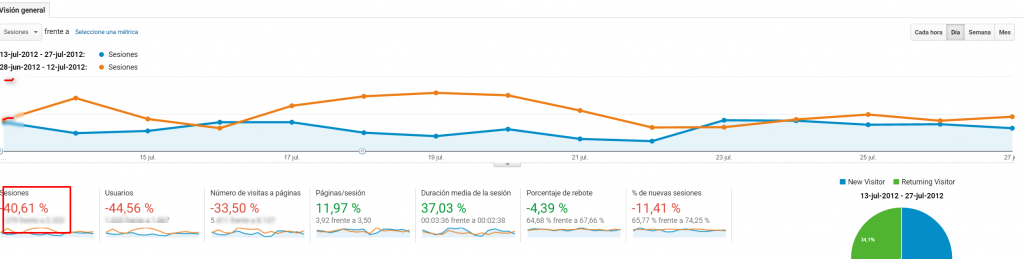

Actualización a 27 de Julio

Webmaster Tools muestra un aumento del número de impresiones alrededor del 400% para el 24 de Julio. Esto puede indicar los primeros síntomas de recuperación. El tráfico crece pero a menor medida. He estudiado el efecto en los rankings de algunas KW principales para sacar un patrón:

- 50 KW primarias sufren, a fecha de 25 de Julio, una caída media de 9,1 posiciones con respecto a antes de los errores. El tráfico derivado de esas KW se reduce al 35% del habitual. – 50 KW secundarias sufren, a fecha del 25 de Julio, una caída media de 40,2 posiciones con respecto a antes de los errores. El tráfico derivado de esas KW se reduce al 15% del habitual.

- 100 KW long tail sufren caídas medias de 2 posiciones. Creo que las KW principales se están recuperando y que posiblemente hayan sufrido también el -40 que actualmente tienen las KW secundarias, solo que no he podido monitorizarlas antes. Esto lo digo por la caída de tráfico asociado a las KW principales que puedo detectar en Analytics. Las KW long tail puede que no hayan sufrido demasiado o que se hayan recuperado más rápido, tengo que seguir mirando y filtrando tráfico.

- Mi opinión a día de hoy, es que puede que muchas KW hayan sufrido un -40 (aquellas URL que dieran fallos menos número de veces) y otras URL directamente han salido de TOP100 y están volviendo a tomar posiciones.

Actualización a 8 de Octubre

Parece que el sitio ha recuperado su tráfico anterior a los errores 12 semanas (3 meses / 90 días) después. Esto no es únicamente debido a estacionalidad (ya sabemos que el verano afecta) porque los rankings de las KW principales estaban realmente afectados por una penalización.

Las posiciones de las KW en las serps se han ido recuperando paulatinamente, y se han hecho algunas acciones de linkbuilding buscando trust sobre todo hacia la home, solo algunos deep links a tercer nivel. Mucho contenido nuevo (ya hablamos de las sospechas acerca de posible penalización por duplicado) y una considerable mejora en los tiempos de carga y respuesta del servidor. Pero ninguna de las acciones que hemos hecho han sido algo que no se haga habitualmente cuando estás tratando de tener un sitio optimizado. No se ha hecho nada fuera de lo común para tratar de recuperar el efecto de la penalización antes de tiempo. Se ha seguido haciendo lo que estaba previsto, eso sí, monitorizando muy bien cada cosa.

En fin, la conclusión que podemos sacar, en base únicamente a lo que hemos experimentado y sufrido en nuestras carnes es la siguiente: Si se generan errores 500 durante más de 7 días, para más de un 50% de las consultas de urls y Googlebot te rastrea hasta un 85% de las urls de tu site… te cae un -40 de media a tus KW, muchas urls se van fuera del índice y tardas en recuperar unos 90 días el tráfico que tenías antes. Así lo dejo, a grosso modo.

Por supuesto, hay muchas más cosas interesantes que hemos aprovechado para probar e investigar. El que esté interesado no tiene más que escribirnos y comentarnos la jugada!